حرب الجدولة: Kubernetes في مواجهة Slurm – من يفوز في معركة الذكاء الاصطناعي؟

بتذكر زمان، لما كنت شغال على مشروع مناقسة لاحد الجامعات، كان لازم ندرب نموذج تعلم آلي ضخم. كنا محتارين بين استخدام سيرفرات الجامعة اللي بتعتمد على Slurm، أو نرفع كل شي على Kubernetes على AWS. بالاخر، اخترنا Slurm عشان كان أسهل في الإعداد وأسرع في التدريب، بس يا ريتنا سمعنا لنصيحة صاحبي اللي كان بيحكي عن مرونة Kubernetes. تعلمت الدرس بفلوسي، متل ما بيقولوا!

في عالم الذكاء الاصطناعي المتطور باستمرار، يواجه المهندسون والمطورون تحدياً كبيراً: اختيار النظام الأمثل لإدارة موارد الحوسبة. هل نعتمد على Kubernetes، معيار السحابة الحديثة، أم Slurm، عملاق الحوسبة عالية الأداء؟ هذا الصراع ليس مجرد تفضيل تقني، بل هو صراع بين فلسفتين مختلفتين جذرياً في إدارة الموارد.

Slurm: قوة الحوسبة العلمية الصلبة

Slurm (Simple Linux Utility for Resource Management) نشأ في مختبرات الأبحاث والحواسب الفائقة. فلسفته تعتمد على “الجدولة الحتمية” والموارد الحصرية. تخيل عندك مصنع كبير، وكل ماكينة فيه مخصصة لعملية إنتاج محددة. هيك بتشتغل Slurm. لما تشغل وظيفة تدريب ضخمة، بيضمن Slurm حصولها على العتاد المخصص بدون أي تداخل، مما يحقق أقصى استفادة من وحدات GPU ويقلل من زمن الانتقال (Latency) في الاتصالات بين العقد. هذا بيخلي Slurm الخيار الأفضل لتدريب النماذج اللغوية الضخمة (LLMs) اللي بتتطلب استقرار مطلق وأداء يمكن التنبؤ به.

نصيحة عملية: إذا مشروعك بيركز بشكل أساسي على تدريب نماذج كبيرة ويتطلب تحكم كامل بالموارد، Slurm هو خيارك الأمثل.

Kubernetes: مرونة السحابة وقدرة التوسع اللانهائية

Kubernetes (K8s) نشأ في جوجل لإدارة الخدمات المصغرة (Microservices). فلسفته تعتمد على المرونة، التوسع التلقائي (Autoscaling)، والتعافي الذاتي (Self-healing). تخيل عندك مدينة ذكية، وكل خدمة فيها بتشتغل بشكل مستقل، وإذا تعطلت خدمة، بيتم استبدالها تلقائياً. هيك بتشتغل Kubernetes. هو مصمم للتعامل مع الفشل كأمر طبيعي، حيث بيقوم بإعادة جدولة الحاويات (Pods) عند تعطل العقد. بينما يعتبر K8s مثالياً لمرحلة “الاستدلال” (Inference) وتقديم النماذج كخدمات API، فهو بيعاني تقليدياً في كفاءة جدولة وظائف التدريب الضخمة والمترابطة بإحكام (Tightly coupled jobs).

نصيحة عملية: إذا مشروعك بيتطلب نشر سريع وتوسع مرن، وخصوصاً في مرحلة الاستدلال، Kubernetes هو خيارك الأفضل.

Slurm-on-K8s: هل هو الحل الأمثل؟

الوضع الحالي معقد، بس الحلول بدأت تظهر. المؤسسات اللي بتبني منصات ذكاء اصطناعي شاملة (End-to-End) من البيانات إلى الإنتاج بتفضل Kubernetes لتوحيد المكدس التكنولوجي وتبسيط عمليات CI/CD. وللتغلب على قصور Kubernetes في التدريب، ظهرت مشغلات (Operators) وأطر عمل مثل Kueue و Volcano اللي بتحاول تجلب قدرات الجدولة المتقدمة (مثل Gang Scheduling و Topology Awareness) لبيئة K8s.

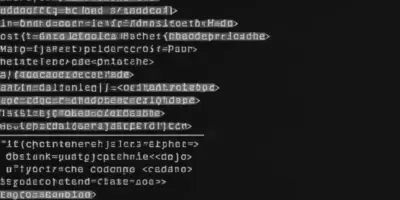

مثال على استخدام Kueue في Kubernetes:

apiVersion: kueue.x-k8s.io/v1beta1

kind: Queue

metadata:

name: my-queue

spec:

cohort: default

---

apiVersion: kueue.x-k8s.io/v1beta1

kind: LocalQueue

metadata:

name: my-local-queue

spec:

queue: my-queue

في المقابل، المختبرات البحثية البحتة اللي بتركز فقط على التدريب وما بتهتم بخدمة النماذج للمستخدمين النهائيين، لسه متمسكة بـ Slurm لبساطته وكفاءته الخام. النموذج الهجين اللي بيجمع بين الاثنين – استخدام Slurm للتدريب الثقيل و Kubernetes للاستدلال والخدمات – لسه خيار شائع، بس بيفرض عبء تشغيلي مضاعف لإدارة نظامين مختلفين.

متى تختار Slurm ومتى تختار Kubernetes؟

- اختر Slurm إذا:

- مشروعك بيركز على تدريب نماذج كبيرة ويتطلب تحكم كامل بالموارد.

- بتحتاج لأداء يمكن التنبؤ به واستقرار عالي.

- الفريق تبعك متمرس في إدارة أنظمة HPC.

- اختر Kubernetes إذا:

- مشروعك بيتطلب نشر سريع وتوسع مرن.

- بتحتاج لتبسيط عمليات CI/CD.

- الفريق تبعك متمرس في إدارة أنظمة السحابة.

- اختر الحل الهجين إذا:

- مشروعك بيتطلب كلا من التدريب الثقيل والاستدلال المرن.

- مستعد تتحمل عبء تشغيلي مضاعف.

الخلاصة: لا يوجد حل واحد يناسب الجميع 🤷♂️

في النهاية، الاختيار بين Kubernetes و Slurm بيعتمد على احتياجات مشروعك وموارد فريقك. لا يوجد حل واحد يناسب الجميع. الأهم هو تفهم نقاط القوة والضعف لكل نظام، وتقييم احتياجاتك بشكل دقيق، واختيار الحل اللي بيناسبك. تذكر دائماً، التكنولوجيا هي مجرد أداة، والهدف هو تحقيق أهدافك بأفضل طريقة ممكنة. بالتوفيق!