مقدمة: لما الذكاء الاصطناعي و التوظيف؟ 🤖

بتذكر مرة، كنت شغال على مشروع لتطوير نظام ذكاء اصطناعي لشركة توظيف كبيرة. الشركة كانت بتعاني من كمية طلبات التوظيف المهولة، وكانوا بدهم طريقة أسرع وأكثر كفاءة لفرز المرشحين. الفكرة كانت إن الذكاء الاصطناعي يحلل السير الذاتية، ويحدد أفضل المرشحين بناءً على معايير محددة مسبقًا.

في البداية، كنا متحمسين جداً للإمكانيات الهائلة اللي ممكن يقدمها الذكاء الاصطناعي. تخيل، تقليل الوقت والجهد اللازمين لفرز مئات، بل آلاف الطلبات! لكن مع التقدم في المشروع، بدأت تظهر أسئلة أخلاقية مهمة: كيف نضمن أن النظام ما يكون متحيز ضد فئة معينة من المرشحين؟ كيف نضمن الشفافية في عملية الاختيار؟ وكيف نحافظ على خصوصية بيانات المرشحين؟

هذا الموقف خلاني أفكر بعمق في أهمية الأخلاقيات في مجال الذكاء الاصطناعي، خاصة في مجال حساس زي التوظيف، اللي بياثر بشكل مباشر على حياة الناس.

ما هي أخلاقيات الذكاء الاصطناعي في التوظيف؟ 🤔

أخلاقيات الذكاء الاصطناعي في التوظيف بتتعلق بالمبادئ والقيم اللي بتوجه تصميم وتطوير واستخدام أنظمة الذكاء الاصطناعي في عمليات التوظيف المختلفة، بدءًا من الإعلان عن الوظائف ووصولًا إلى اختيار المرشحين المناسبين. الهدف هو ضمان أن تكون هذه العمليات عادلة وشفافة وغير متحيزة، وتحترم حقوق المرشحين.

لماذا هي مهمة؟ 💡

* العدالة والمساواة: تضمن أنظمة الذكاء الاصطناعي العادلة حصول جميع المرشحين على فرصة متساوية، بغض النظر عن خلفياتهم أو جنسهم أو عرقهم.

* الشفافية والمساءلة: يجب أن يكون المرشحون على علم بكيفية استخدام الذكاء الاصطناعي في عملية التوظيف، وأن يكونوا قادرين على فهم أسباب القرارات المتخذة.

* حماية الخصوصية: يجب حماية بيانات المرشحين الشخصية من الوصول غير المصرح به أو الاستخدام غير الأخلاقي.

* بناء الثقة: عندما تكون عمليات التوظيف عادلة وشفافة، تزيد ثقة المرشحين والموظفين في الشركة.

تحديات أخلاقية تواجه الذكاء الاصطناعي في التوظيف 😥

* التحيز في البيانات: إذا كانت البيانات التي يتم تدريب الذكاء الاصطناعي عليها متحيزة، فإنه سينتج عنه نتائج متحيزة أيضًا. مثال: إذا كانت معظم السير الذاتية في قاعدة البيانات تعود لذكور، فقد يفضل النظام الذكور على الإناث.

* صندوق أسود: في بعض الأحيان، يكون من الصعب فهم كيف اتخذ الذكاء الاصطناعي قرارًا معينًا، مما يجعل من الصعب تحديد ما إذا كان القرار عادلاً أم لا.

* نقص الشفافية: قد لا يكون المرشحون على علم بكيفية استخدام الذكاء الاصطناعي في عملية التوظيف، أو ما هي المعايير التي يتم استخدامها لتقييمهم.

* التأثير على التنوع: إذا لم يتم تصميم أنظمة الذكاء الاصطناعي بعناية، فقد تؤدي إلى تقليل التنوع في القوى العاملة.

حلول عملية لمواجهة التحديات الأخلاقية 💪

* تنظيف البيانات: التأكد من أن البيانات التي يتم تدريب الذكاء الاصطناعي عليها متنوعة وغير متحيزة.

* الشفافية: توضيح كيفية استخدام الذكاء الاصطناعي في عملية التوظيف، والمعايير التي يتم استخدامها لتقييم المرشحين.

* المساءلة: تحديد المسؤوليات بوضوح، والتأكد من وجود آليات للمراجعة والتدقيق.

* التدريب والتوعية: تدريب الموظفين على استخدام الذكاء الاصطناعي بشكل أخلاقي، وتوعية المرشحين بحقوقهم.

* الرقابة البشرية: التأكد من وجود رقابة بشرية على قرارات الذكاء الاصطناعي، خاصة في المراحل الحاسمة من عملية التوظيف.

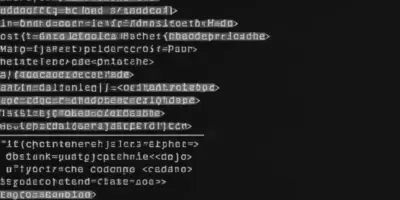

مثال كود: التحقق من التحيز في البيانات

هذا مثال بسيط بلغة Python باستخدام مكتبة `pandas` للتحقق من وجود تحيز جنسي في بيانات السير الذاتية:

“`python

import pandas as pd

# قراءة البيانات من ملف CSV

data = pd.read_csv(‘resumes.csv’)

# حساب عدد الذكور والإناث

gender_counts = data[‘gender’].value_counts()

print(gender_counts)

# فحص النسبة

if gender_counts[‘Male’] > gender_counts[‘Female’] * 1.2:

print(“تحذير: قد يكون هناك تحيز جنسي في البيانات.”)

else:

print(“البيانات متوازنة نسبيًا.”)

“`

**نصيحة:** هذا مثال بسيط، ولكن يجب استخدام أدوات أكثر تعقيدًا لتحليل التحيز بشكل شامل.

نحو مستقبل عادل وشفاف في التوظيف ✨

لتحقيق مستقبل عادل وشفاف في التوظيف باستخدام الذكاء الاصطناعي، يجب على الشركات والمطورين والباحثين التعاون معًا لتطوير وتنفيذ أفضل الممارسات الأخلاقية.

خطوات عملية: 🔑

1. وضع مدونة قواعد سلوك أخلاقية: تحدد المبادئ والقيم التي توجه استخدام الذكاء الاصطناعي في التوظيف.

2. إجراء تقييمات منتظمة للأثر الأخلاقي: لتقييم المخاطر المحتملة وتحديد الحلول المناسبة.

3. إشراك أصحاب المصلحة: بما في ذلك المرشحين والموظفين والخبراء في مجال الأخلاقيات، في عملية تطوير وتنفيذ أنظمة الذكاء الاصطناعي.

4. الاستثمار في البحث والتطوير: لتطوير أدوات وتقنيات جديدة تساعد على ضمان العدالة والشفافية في التوظيف.

الخلاصة: الذكاء الاصطناعي سلاح ذو حدين ⚔️

الذكاء الاصطناعي يمتلك القدرة على إحداث ثورة في مجال التوظيف، لكن يجب استخدامه بحذر ومسؤولية. تذكر دائماً:

* البيانات النظيفة هي الأساس. 🧹

* الشفافية تبني الثقة. 🤝

* الرقابة البشرية ضرورية. 👀

**نصيحة أخيرة:** لا تعتمد بشكل كامل على الذكاء الاصطناعي في اتخاذ القرارات المتعلقة بالتوظيف. استخدمه كأداة للمساعدة، ولكن احتفظ دائمًا باللمسة الإنسانية.